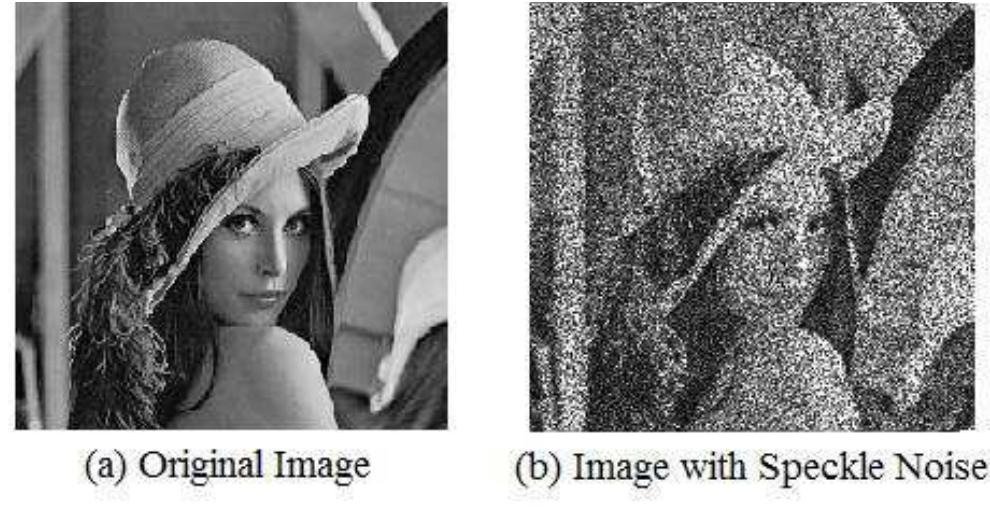

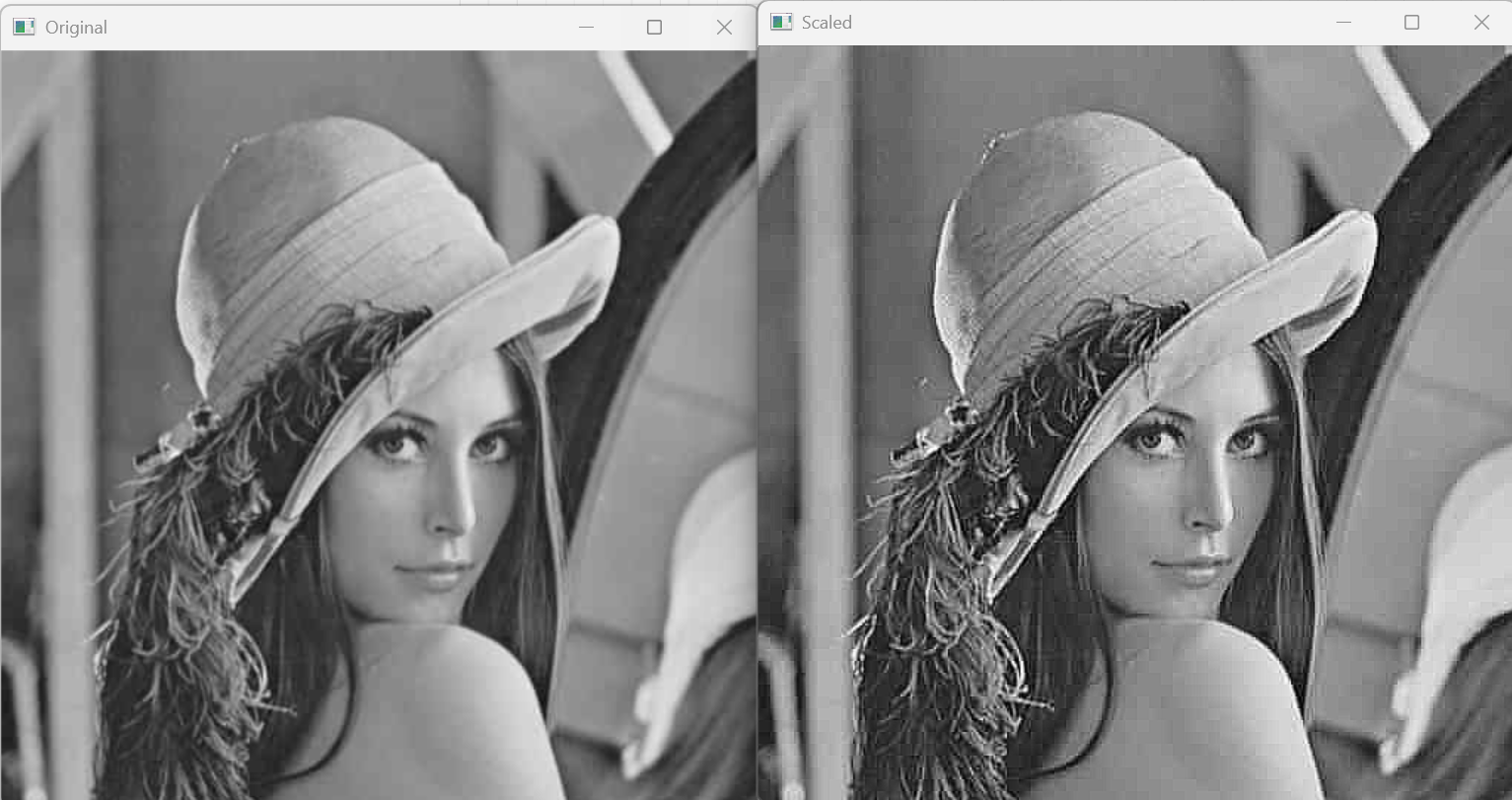

이 포스팅에서는 Image Degradation과 Image Noise에 대해서 알아본다. 1. Image Degradation TypeImage Restoration(복원)의 목표는 이미지의 degradation(손상)을 줄이는 것 이다.좋은 이미지 복원을 위해서는 이미지의 손상에 대한 이해가 필요하다. 이미지 손상의 유형은 다음과 같다.노이즈이미지에 무작위 값이 추가되어서 이미지의 세부 정보를 왜곡시키는 현상을 노이즈라고 한다.이미지 센서, 전송과정 중 손상, 조명 등 다양한 원인에 의해 발생한다.대표적으로 가우시안 노이즈, Salt&Pepper 노이즈, 포아송 노이즈 등이 있다.Out of focus Blur렌즈의 초점이 정확하지 않을 때 발생한다.렌즈가 가정한 초점 거리와 피사체의 거리가 다른경우..